为了提高英语水平和保持技术成长,开始按计划翻译一些短篇和博客,有问题欢迎讨论👻

原文:Bias in AI is a mirror of our culture

原作者:Arvind Sanjeev

正文

在今天的生活中,人类更多的是与 AI 模型互动,而非人类。无论是在 Youtube 和 Netflix 上进行娱乐活动,还是在 Instagram 和 TikTok 上寻找灵感,在 Tinder 和 Hinge 上寻找 朋友, AI 模型都会决定我们应该与哪些人类和内容互动。AI 模型已经在不知不觉地控制着我们的生活。

我们把决策权交给了算法,现在它们可以决定哪些人可以获得住房或医疗保险,谁会被雇佣或者被大学录取,我们的信用评分等等。人们希望通过公式将人类的看法剔除,使机器能够做出公平公正的决定,然而,训练这些模型的数据就是来自于一个从根本上存在偏见的社会;要完全消除这些偏见是不可能的。AI 只是将它们又反射给我们。

Algorithmic racism

种族歧视算法正在把人们送进监狱。

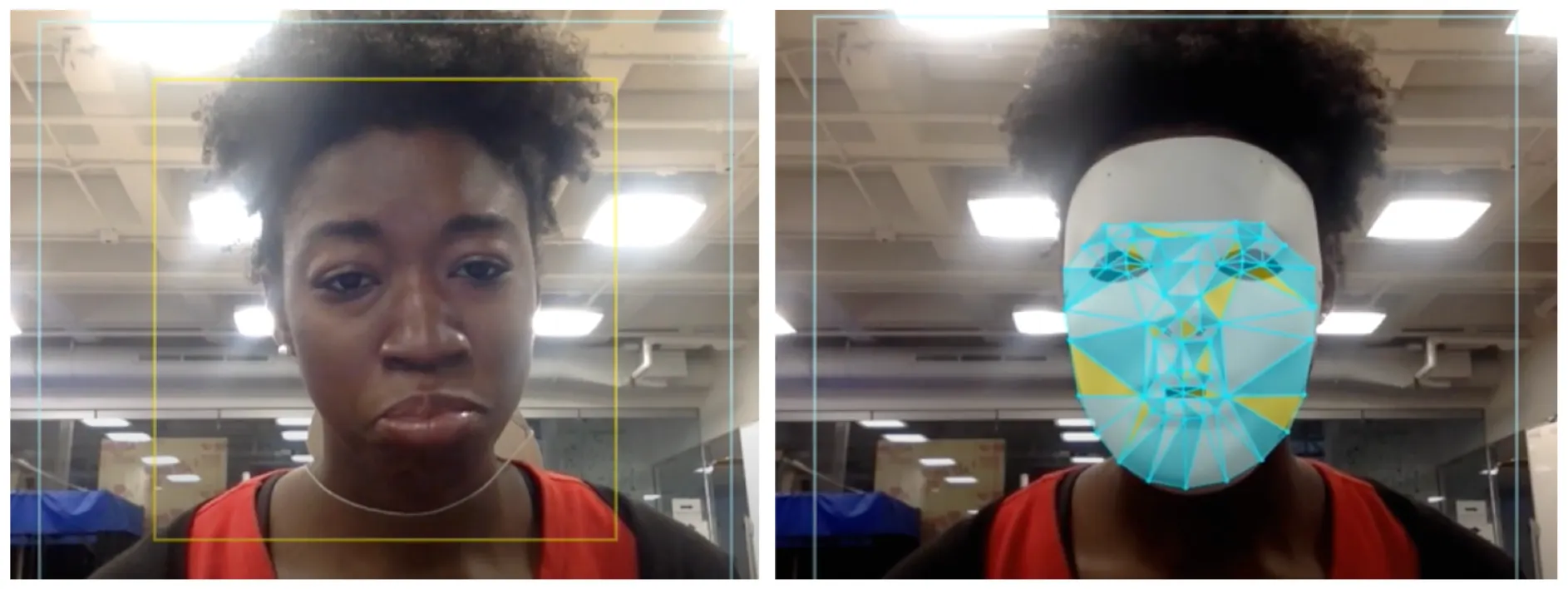

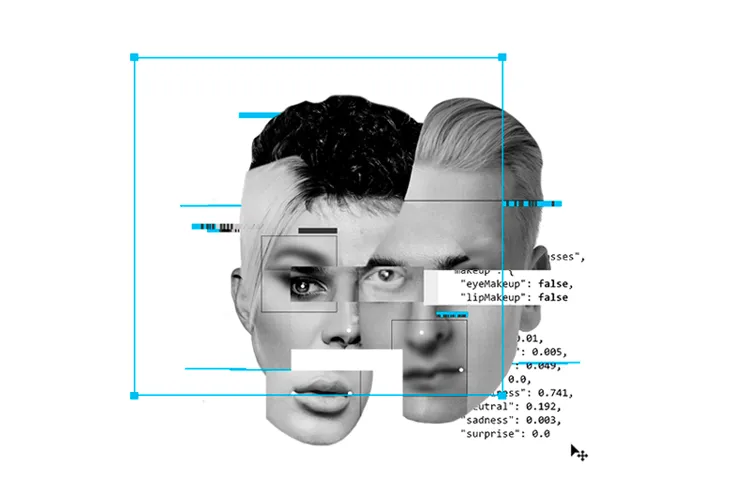

在2015年,Media Lab 的 Joy Buolamwini 发现,当时所有的人脸识别算法(来自 IBM 、 Microsoft 等公司)都无法检测到她的脸,因为她是一个黑人女性。然而,当她带上白色面罩时,这些算法又能看到她了。她注意到,在分析黑人女性和白人男性时,误差达到35%。我们过去还有许多其他的例子:

- 在2015年,谷歌的图像标记算法把一对黑人朋友标为“大猩猩”

- Flicker 的系统也犯了同样的错误,用“动物”和“猿猴”标记了一个黑人。

- Nikon 的相机可以检测一个人是否持续眨眼,但它却告诉一位亚洲用户她的眼睛是闭着的

- HP 的网络摄像头在2009年可以轻松追踪到白人的脸,但却看不到黑人的脸

“We will not solve the problems of the present with the tools of the past. The past is a very racist place. And we only have data from the past to train Artificial Intelligence.”

— Trevor Paglen, artist and critical geographer

有偏见的人脸识别算法甚至错误地将黑人男子逮捕并送进监狱。以下是美国执法人员使用种族歧视决策工具的两个例子:

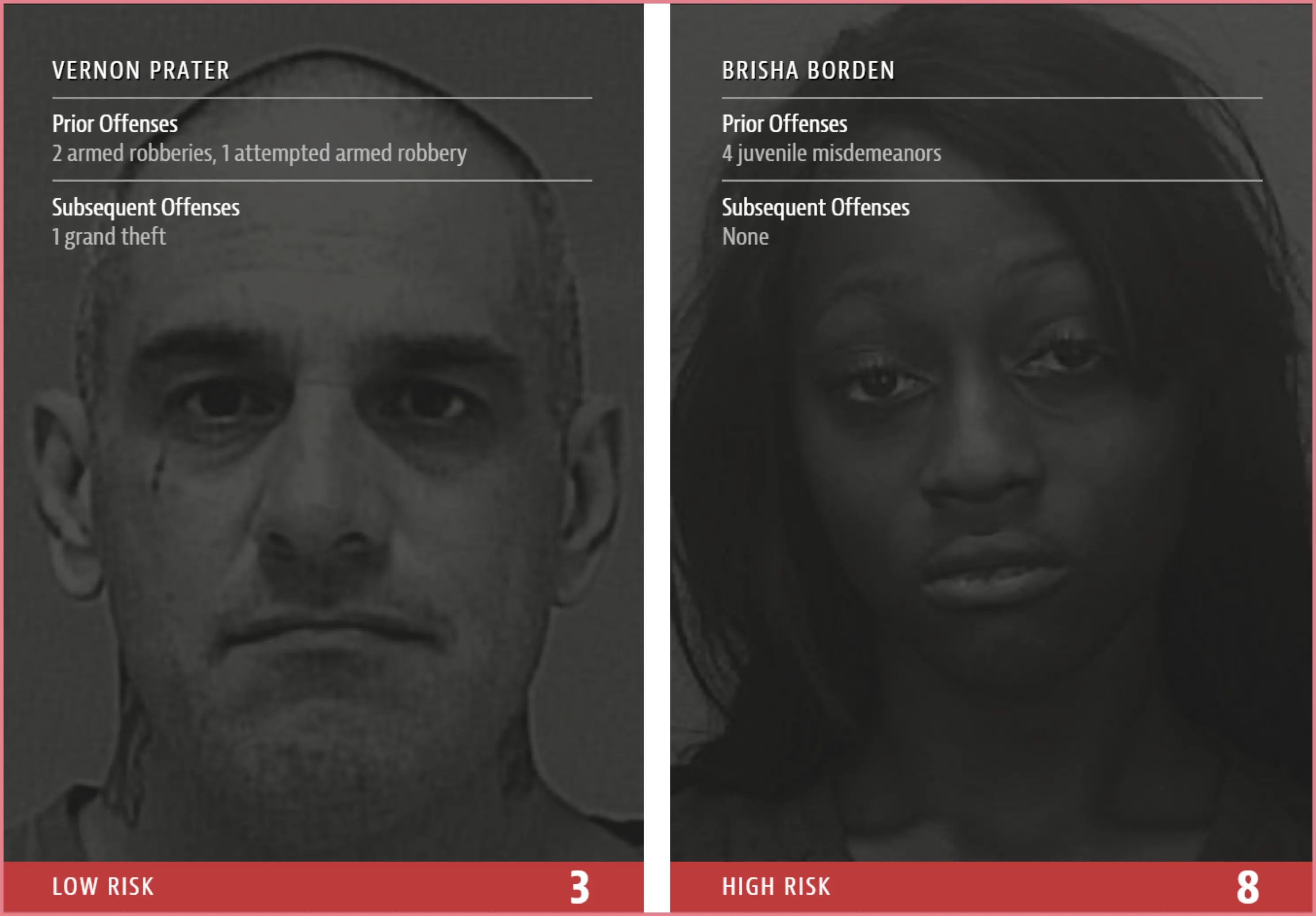

- COMPAS:美国法官和假释官使用的一种累犯预测软件,用于确定刑事被告的风险程度,进而影响他们的量刑。该算法不公平地将黑人和西班牙裔人归类为比其他人更危险的人。

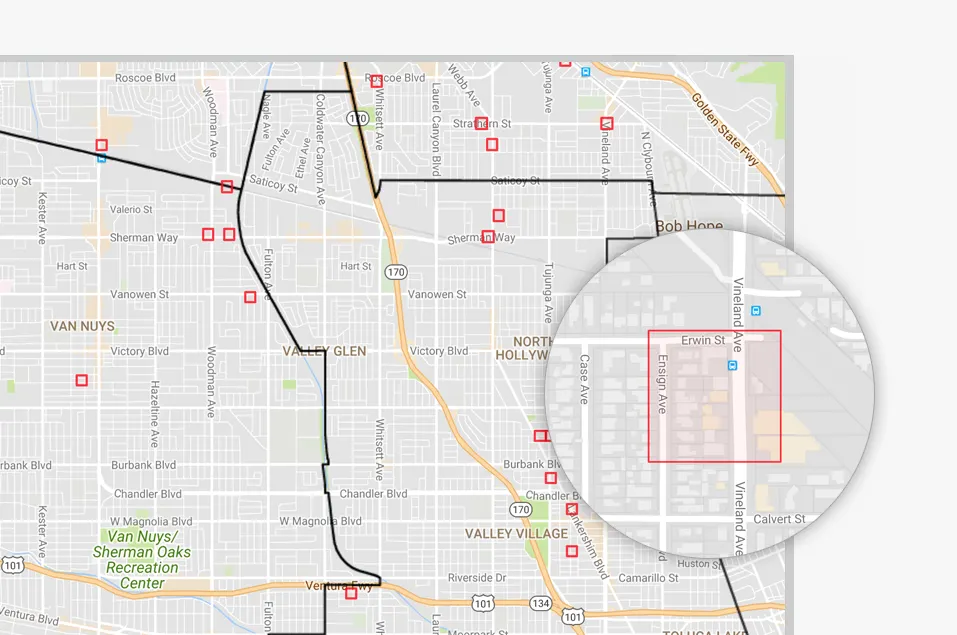

- PrePol: Predictive Policing 是一种“少数民族报告”式的犯罪预测软件,由警方用来确定哪些社区应该比其他社区进行更多的巡逻。由于这种有偏见的算法,黑人社区总是受到更多的巡逻和骚扰。

Black men are six times more likely to be incarcerated by police than white men and 21 times more likely to be killed by them.

— Cathy O Neil, Weapons of Math Destruction

This is a damn trap pic.twitter.com/UssHF5MtNk

— Saturday Night Live - SNL (@nbcsnl) March 13, 2022

Gender bias

Binary algorithms 加强了刻板印象

Subspring 是有史以来第一个由 AI 创作的短片。Oscar Sharp用科幻电影脚本训练模型,创造出这部作品。2021年,当他尝试用动作电影剧本训练模型做类似的事情时却大吃一惊。因为他注意到,所有生成的故事都只有一个稳重的男性角色,而唯一的女性角色(恋爱对象)在整个故事中都只是被称为”女朋友”

OpenAI的研究员发现了在自己的软件上描述男性和女性时产生的十大有偏见的词汇。对于男性来说,”large”、”mostly”、”lazy”、”fantastic “和 “eccentric “是最多的词汇。而对于女性来说,则是 “optimistic”、”bubbly”、”naughty”、”easy-going “和 “petite”。研究员写道:“我们发现,女性更常用以外表为导向的词汇描述自己”

Machine learning models learn the biases back in data and reflect them back to us

— Bindu Reddy (@bindureddy) October 19, 2021

Hungarians have no gendered pronouns but apparently, Google Translate has learnt all the gender stereotypes! 😱😱 pic.twitter.com/Hi0r62PMpF

Transphobic algorithms

我们已经生活在一个性别歧视的世界里,但 AI 让情况变得更糟糕。

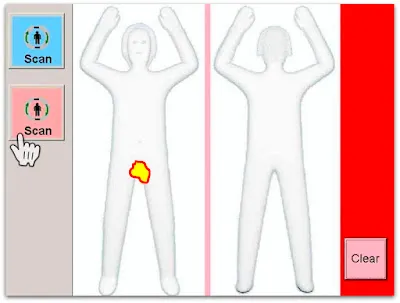

Automatic Gender Recognition(AGR)是 transphobic algorithms 的最佳示例。AGR广泛用于机场、商场等公共场所。当算法无法标记 non-binary 人的性别时,就会给他们带来很多羞辱和不适,从而引起他们更多的警觉和关注。

“Every trans person you talk to has a TSA horror story. The best you can hope for is just to be humiliated; at worst, you are going to be harassed, detained, subjected to very invasive screenings, etc. Trans people or gender non-conforming people who have a multi-racial or Middle Eastern descent are most probable to have a negative airport security incident.”

— Kelsey Campbell, Founder Gayta Science

了解更多 transphobic algorithms:

- AI software defines people as male or female. That’s a problem。作者:Rachel Metz, CNN

- A transgender AI researcher’s nightmare scenarios for facial recognition software,作者:Khari Johnson,VentureBeat

- Counting the Countless,作者:Os Keyes, Real life mag

Biased hiring algorithms

如果你是一个叫 Jared 的白人,在高中打过曲棍球,你就能得到这份工作!

使用 AI-powered 简历筛选工具的灵感来自于盲选,即乐团在封闭帷幕后选择音乐家。这可以让他们忽略艺术家的性别、种族、声誉等因素。然而,大多数招聘算法不可避免地会产生偏见。

Amazon就是一个例子;他们的招聘和解雇算法都臭名昭著。他们的招聘算法偏爱白人男性,而不是其他人群,而解雇算法则会在没有明确理由或者根本没有人为监督的情况下解雇工厂工人。

After the company trained the algorithm on 10 years of its own hiring data, the algorithm reportedly became biased against female applicants. The word “women,” like in women’s sports, would cause the algorithm to specifically rank applicants lower.

— Companies are on the hook if their hiring algorithms are biased, QZ

Who’s fighting back?

AI 审计是最广为接受的减少偏见的技术之一。这个框架被广泛用于确定AI模型是否存在偏见、歧视或其他没发现的偏见。像Meta和Microsoft这种公司已经拥有内部审计团队来分析这些模型,但外部机构如ORCAA、ProPublica、NIST等机构也在进行审计。AJL(Algorithmic Justice League)的论文《Who audits the auditors》详细描述了AI审计生态系统的情况。

以下是一些减少AI偏见的其他例子:

- Standards for Identifying and Managing Bias in Artificial Intelligence:NIST制定的guideline,用于支持可信和负责性的AI发展

- Themis:一款审计软件,用于设计出算法中的偏差,揭露出AI模型中隐藏的不平衡。

- Diffusion bias explorer:来自HuggingFace的Sasha Luccioni的项目,揭示了Stable Diffusion中的隐藏偏见。

- The Princeton web accountability and transparency project:这是一个利用机器人在网络上伪装成黑人、亚洲人、穷人、女性或跨性别者,并尝试在未被代表的数据集中代表这些少数群体的项目。

- Feminist dataset: 这个项目让社区参与创建数据集,以实现数据收集的透明方法。

- Ellpha:这个项目旨在创建性别平衡的数据集,使其能够真实地代表现实世界。

- Queer in AI:提高在 AI/ML 领域同性恋问题的认识,培养同性恋研究人员和科学家群体。

- Gayta science:利用数据科学技术捕捉、结合和提取见解,为LGBTQ+群体的经历赋予表达声音的机会。

- Q:这是第一款自称雌雄同体的人的声音训练的无性别语音助手。这些声音的频率范围在145赫兹到175赫兹之间,正好位于男性和女性的声音范围之间的甜蜜点。

有偏见的算法被用作掩盖不公平做法和裁决少数群体的工具。通过以上的例子,希望你可以开始对 AI 所做的决策产生质疑。所以,下次当有人说这是一个由客观机器做出的公正决定时,就不会成为对话的终结者;相反,它会引起关于 AI 中偏见的全新讨论。

High-tech tools have a built-in authority and patina of objectivity that often lead us to believe that their decisions are less discriminatory than those made by humans. But bias is introduced through programming choices, data selection, and performance metrics. It redefines social work as information processing, and then replaces social workers with computers. Humans that remain become extensions of algorithms.

— Virginia Eubanks, Automating Inequality

有关此主题及其他主题的更多资源,请查阅本手册《AI’s unintended consequences》。本文是探讨 unintended consequences of AI 四部系列文章中的第二章